El libro El Quark y el Jaguar escrito por el físico Murray Gell-Mann tiene cuatro partes:

- Primera Parte: Lo Simple y lo Complejo.

- Segunda Parte: El Universo Cuántico.

- Tercera Parte: Selección y adaptación.

- Cuarta Parte: Diversidad y Sostenibilidad.

Portada del libro El Quark y el Jaguar escrito por Murray Gell-Mann

Prefacio

El objetivo del autor en este libro es presentar su propia visión sobre una síntesis que está emergiendo en los límites de la investigación acerca de la naturaleza del mundo que nos rodea: el estudio de lo simple y de lo complejo.

Este libro investiga las conexiones entre las llamadas leyes fundamentales de la física y la asombrosa complejidad y diversidad del mundo natural que nos rodea.

Este libro investiga las conexiones entre las llamadas leyes fundamentales de la física y la asombrosa complejidad y diversidad del mundo natural que nos rodea.

La frase: "El quark y el jaguar" aparece en un poema de Arthur Sze y ambas imágenes se ajustan a lo que el autor quería explicar. Los quarks son los ladrillos básicos de la materia. Todo objeto está constituido de quarks y electrones. Incluso el jaguar, pero exhibiendo una enorme complejidad, resultado de miles de millones de años de evolución biológica.

Este libro está dividido en cuatro partes. La primera está dedicada principalmente a las relaciones entre conceptos diversos de simplicidad y complejidad, así como a los sistemas complejos adaptativos (aquellos que aprenden o evolucionan del mismo modo que lo hacen los seres vivos). También se discute el papel de la teoría de la ciencia, así como el problema de cuales son las ciencias más fundamentales, junto con la cuestión de lo que se entiende por reduccionismo.

La segunda parte trata de las leyes fundamentales de la física, aquellas que gobiernan el cosmos y las partículas elementales que componen toda la materia del universo. Aparecen aquí los quarks, así como las supercuerdas, que ofrecen por primera vez en la historia una seria posibilidad de teoría unificada de todas las partículas e interacciones de la naturaleza.

La tercera parte recoge las presiones selectivas que actúan sobre los sistemas complejos adaptativos, especialmente en la evolución biológica, el pensamiento creativo humano y algunos aspectos del comportamiento de las sociedades humanas.

La última parte difiere bastante del resto, pues se centra más en asuntos de política y legislación.

Primera Parte: Lo Simple y lo Complejo

1. Prólogo: un encuentro en la jungla

Las leyes de la física son exactas. Sin embargo las leyes de las ciencias sociales son aproximadas. Aunque las partículas elementales no tienen individualidad (todos los fotones del universo son exactamente iguales), las leyes mecanocuánticas dan ciertamente lugar a la individualidad, como nuestro planeta y, mediante evolución biológica, objetos particulares capaces de adaptarse y aprender. Y luego los seres humanos capaces de desarrollar el lenguaje y la civilización y de descubrir las leyes fundamentales de la naturaleza.

¿Cuál es la distinción entre los sistemas complejos adaptativos que experimentan procesos como el aprendizaje y la evolución biológica y los sistemas que, como las galaxias o las estrellas, experimentan otro tipo de evolución no adaptativa?

En este libro se explora la relación entre lo simple y lo complejo, entre lo universal y lo individual, entre las leyes básicas de la naturaleza y los asuntos individuales y cotidianos.

2. Luz temprana

En el título el quark simboliza las leyes físicas básicas y simples que gobiernan el universo y toda la materia que este contiene. El jaguar representa la complejidad esquiva del mundo que nos rodea, especialmente tal como se manifiesta en los sistemas complejos adaptativos y que eluden una visión analítica clara.

Las leyes físicas fundamentales tienen un papel en la diversidad de la naturaleza y el modo fascinante en que se organiza. Este papel tiene que ver con el papel de la historia en la Mecánica Cuántica, y la explicación última reside en el estado primigenio del universo.

Un maravilloso ejemplo de esa simplicidad en los principios de la naturaleza es la ley de la gravedad y, concretamente, la Teoría General de la Relatividad.

La evolución física del universo dio lugar a la individualidad de los planetas como la Tierra y a la aparición de sistemas complejos adaptativos ligados a los procesos de origen de la vida y la evolución biológica.

Lo que tienen en común estos procesos es la existencia de un sistema complejo adaptativo que adquiere información acerca tanto de su entorno como de la interacción entre el propio sistema y dicho entorno, identificando regularidades y actuando consecuentemente en el mundo real.

Algunos sistemas complejos adaptativos del planeta Tierra

3. Información y complejidad

Los sistemas complejos adaptativos se hallan sujetos a las leyes de la naturaleza, que a su vez se fundamentan en las leyes físicas de la materia y el universo. Por otra parte, la existencia de tales sistemas solo es posible en condiciones particulares.

Para examinar el universo y la estructura de la materia podemos seguir la misma estrategia adoptada en el estudio de los sistemas complejos adaptativos: concentrarse en la información. ¿Cuáles son las regularidades y donde entran la contingencia y la arbitrariedad?

En el siglo XVIII se creía que conociendo el estado del universo en un momento dado, se podría predecir su estado en un instante futuro. Hoy sabemos que esto es falso. El universo es mecanocuántico, lo que implica que, aún conociendo su estado inicial y las leyes fundamentales de la materia, solo puede calcularse un conjunto de probabilidades para las diferentes historias posibles.

Además está el fenómeno del caos, en el que la evolución de un proceso dinámico no lineal es tan sensible a las condiciones iniciales que un cambio minúsculo en la situación al principio del proceso se traduce en una gran diferencia al final.

4. Aleatoriedad

Para discutir con mayor profundidad el concepto de complejidad efectiva es esencial examinar detalladamente la naturaleza de los sistemas complejos adaptativos. Veremos que el aprendizaje y la evolución requieren, entre otras cosas, la capacidad de distinguir lo aleatorio de lo regular. De esta forma, la complejidad efectiva de un sistema esta relacionada con la descripción de sus regularidades por parte de otro sistema complejo adaptativo que lo esté observando.

5. Un niño aprendiendo a hablar

Puesto que un sistema complejo adaptativo extrae regularidades de entre lo aleatorio, es posible definir la complejidad en términos de la longitud del esquema empleado por un sistema complejo adaptativo para describir y predecir las propiedades y regularidades de una sucesión de datos de entrada.

Se necesitan muchos datos de entrada para distinguir las regularidades de la aleatoriedad. Cuando un sistema complejo adaptativo recibe una sucesión de datos arbitrariamente larga puede buscar sistemáticamente regularidades, pero no hay un procedimiento exhaustivo para buscar todas las regularidades posibles.

Para buscar regularidades, un sistema complejo adaptativo divide los datos de entrada en partes comparables entre sí e investiga sus rasgos comunes. La información común a muchas partes o «información mútua», sirve para diagnosticar regularidades pero no para medir la complejidad efectiva.

Una vez se han identificado ciertas regularidades y se ha elaborado una concisa descripción de ellas, es la longitud de la descripción lo que mide la complejidad efectiva.

Para que la complejidad efectiva tenga un valor apreciable el contenido de la información algorítmica no debe ser ni demasiado bajo ni demasiado alto. El sistema no debe estar ni demasiado ordenado ni demasiado desordenado.

La aleatoriedad pura tiene gran cantidad de información algorítmica y, sin embargo, complejidad efectiva nula. Por otro lado en una cadena de bits iguales a 1 tanto la información algorítmica como la complejidad efectiva son nulas (la descripcion «todo 1» es corta).

El contenido de información algorítmica es igual al contenido de información aparentemente regular más el contenido de información aparentemente estocástica.

En una secuencia de organismos cada vez menos sofisticados el aprendizaje individual tiene cada vez menos relevancia en comparación con los instintos acumulados en el transcurso de la evolución biológica. Pero la propia evolución biológica puede ser descrita a su vez como un sistema complejo adaptativo, incluso en los organismos más sencillos.

La complejidad efectiva de una bacteria, en el sentido de longitud de un esquema o descripción, está relacionada con la longitud del genoma. La longitud de la parte relevante del genoma proporciona una medida interna aproximada de la complejidad efectiva.

Pero esta idea es algo deficiente para comparar genomas y para establecer la complejidad de una especie. Por ejemplo, las diferencias entre los humanos y los primates son sutiles dando una complejidad efectiva similar pero los humanos somos una especie más avanzada.

La empresa científica humana constituye una hermosa ilustración del concepto de sistema complejo adaptativo. Los esquemas son en este caso las teorías, y lo que tiene lugar en el mundo real es la confrontación entre la teoría y la observación.

Las nuevas teorías deben competir con las ya existentes, en parte en cuanto a coherencia y generalidad, pero en último término en cuanto a su capacidad de explicar las observaciones y predecir correctamente otras nuevas. De hecho, la misión del físico teórico no es idear teorías elegantes, sino explicar los resultados de las observaciones.

El proceso por el que las teorías resultan seleccionadas de acuerdo con la experiencia, coherencia y generalidad no es muy diferente de la evolución biológica.

Normalmente, las teorías surgen como resultado de multitud de observaciones. Una teoría se formula como un conjunto de principios simples, expresados de forma concisa como, por ejemplo, un conjunto de ecuaciones.

Por regla general, existen varias teorías en competencia que comparten estas características. La bondad de las predicciones de cada teoría, en consonancia con su verificación mediante observaciones, contribuye a determinar su supervivencia.

Las teorías en seria discordancia con las observaciones tienden a ser desplazadas por otras mejores, mientras que las teorías que predicen y explican satisfactoriamente las observaciones tienden a ser aceptadas y sirven de base para teorías futuras.

Falsabilidad e Intriga

El filósofo Karl Popper ha remarcado que el rasgo esencial de la ciencia es que sus teorías son falsables. Las teorías científicas hacen predicciones verificables mediante observaciones posteriores. Cuando una teoría resulta contradicha por observaciones fiables repetidas debe considerarse errónea. La posibilidad del error está siempre presente dando una intriga a toda actividad científica.

Los investigadores y científicos pueden verse influenciados por prejuicios, modas o el deseo de belleza y elegancia en sus teorías que los condicionen de antemano. Esto podría alterar la empresa científica. Pero el método científico se encarga de filtrar y eliminar a largo plazo las teorías que no describen la realidad.

Aunque el funcionamiento de la empresa científica puede ser complejo, el resultado final puede ser una clarificación general brillante, como en el caso de la formulación y verificación de una teoría unificadora.

Teorías que unifican y sintetizan

De vez en cuando, con una teoría se logra una notable síntesis, comprimiendo en un enunciado breve y elegante muchos fenómenos descritos anteriormente por separado y, en cierta forma, de manera inadecuada. Un excelente ejemplo son las Leyes de Maxwell.

Las ecuaciones de Maxwell describen en pocas líneas el comportamiento del electromagnetismo en cualquier parte del universo. Identifican con precisión las regularidades y las comprimen en unas pocas ecuaciones resultando un esquema descriptivo breve.

Como la longitud del esquema es casi cero, ese es el valor de su complejidad efectiva. Es decir, las leyes del electromagnetismo son simples. Aunque a este esquema tuviéramos que añadir información de la notación o de los conceptos matemáticos utilizados, como el ámbito de validez de estas leyes es tan grande, la compresión conseguida seguiría siendo enorme.

La gravitación universal

La gravitación constituye otro caso extraordinario de ley universal. Newton elaboró la primera versión, refinada por Einstein en la Teoría General de la Relatividad. Más allá de predecir nuevas observaciones como la curvatura de los rayos luminosos, la Relatividad General aportó un cambio de paradigma o cambio conceptual. La Relatividad se fundamenta en el principio de equivalencia y, además, unifica el espacio y el tiempo y elimina la acción a distancia.

De hecho, la competencia entre esquemas en el marco de la empresa científica no implica necesariamente que el anterior sea abandonado. Incluso puede ser utilizado con mucha mayor frecuencia que su más preciso sucesor por cuestiones de simplicidad como ocurre con la teoría newtoniana en el ámbito del Sistema Solar.

Igual que el electromagnetismo, la Relatividad General es un prodigio de compresión y, por tanto, una teoría simple.

Por teoría entendemos un sistema coherente de leyes y principios, una explicación más o menos verificada o establecida que da cuenta de hechos o fenómenos conocidos.

La elaboración de una teoría puede conducir no solo a la identificación de regularidades presentes, sino también a una explicación plausible y a su posterior confirmación.

Pero a veces encontramos situaciones menos claras. Podemos hallar regularidades o predecirlas, descubrir que las predicciones se confirman y que no obstsnte pueda tratarse de un modelo cuya explicación última se nos escape. En este caso hablamos de una teoría empírica o fenomenológica.

El quark y el jaguar se encuentran prácticamente en los extremos opuestos de la escala de lo fundamental. La física de partículas elementales y la cosmología son las dos disciplinas científicas más básicas, mientras que el estudio de la materia viva altamente compleja es mucho menos básico.

En el caso de que las matemáticas sean consideradas una ciencia en lugar de solo un lenguaje (puede considerarse discutible porque no esta dedicada a la descripción de la naturaleza y sus leyes), sería la más básica de todas. Esto es así porque estudia todas aquellas estructuras que se dan en las teorías científicas y todas las que podrían haberse dado en otras teorías de mundos hipotéticos. Sería la ciencia de lo que es y de lo que podría haber sido o podría ser.

En cuanto a las otras disciplinas, ¿Qué es lo que hace que una ciencia sea más fundamental que otra? Podría sugerirse que la ciencia A es más fundamental que la B si:

Esto sería coherente con el razonamiento anterior para las matemáticas.

En el caso de la física y la química la primera sería más fundamental porque toda la química puede derivarse, aunque sea complejo, de la física. Un ejemplo sería la Electrodinámica Cuántica basada en la ecuación de Dirac, que explica gran parte de la química siempre que se consideren los núcleos de los átomos como partículas puntuales cargadas e inmóviles.

Para poder derivar las propiedades químicas de las teorías físicas fundamentales hay que aportar las condiciones químicas adecuadas sobre el caso concreto que se desea estudiar.

Sin embargo la química sigue siendo muy válida pues es la única posibilidad factible en los casos complejos imposibles de abordar con las leyes fundamentales de la física.

La explicación de una disciplina en términos de otra mas fundamental se suele denominar reducción. Este hecho también nos dice que las diferentes ciencias forman parte de una estructura conexa en las que unas pueden ser explicadas a través de otras. Esto implica que las diferentes ciencias tienen que estar relacionadas.

En cuanto a la biología, hay consenso en que esta se basa en las leyes de la física y la química, tal y como las leyes de la química surgen de las de la física, y en este sentido todos somos reduccionistas. Sin embargo, como ocurre con la química, sigue siendo muy provechoso estudiar la biología en sus propios términos y en su propio nivel.

Uno de los grandes desafíos de la ciencia contemporánea es el de explorar la mezcla de simplicidad y complejidad, regularidad y aleatoriedad, orden y desorden, escaleras arriba desde la física de partículas y la cosmología hasta el reino de los sistemas complejos adaptativos. Tenemos que aprender la manera como surgieron, a partir del orden, la simplicidad y la regularidad del Universo primigenio, las condiciones intermedias entre orden y desorden que han prevalecido en muchos lugares en épocas posteriores, y que han hecho posible entre otras cosas, la existencia de sistemas complejos adaptarivos como los seres vivos.

A este fin se debe examinar la física fundamental desde la perspectiva de la simplicidad y la complejidad, y preguntarnos sobre el papel desempeñado por la teoría unificada de las partículas elementales, las condiciones iniciales del Universo, la indeterminación de la mecánica cuántica y las incertidumbres de la teoría clásica del caos, en la producción de los patrones de regularidad y aleatoriedad universales que han permitido la evolución de los sistemas complejos adaptativos.

Las leyes fundamentales están sujetas a los principios de la Mecánica Cuántica. Esta teoría es uno de los mayores descubrimientos hechos por el hombre, pero es también uno de los más difíciles de comprender por la mente humana porque va contra nuestra intuición.

El universo consta de materia compuesta de partículas elementales como los electrones y los fotones. Las partículas carecen de individualidad (cada electrón del universo es idéntico a cualquier otro y todos los fotones son intercambiables). Sin embargo cada partícula puede ocupar uno entre un número infinito de estados cuánticos.

Hay dos grandes grupos de partículas: los fermiones que obedecen el principio de exclusión de Pauli, y los bosones, que tienen tendencia a ocupar el mismo estado al mismo tiempo.

Por eso los bosones pueden aumentar su densidad hasta tener un comportamiento prácticamente clásico, como el de los campos electromagnéticos y gravitatorio. Las partículas bosónicas pueden considerarse en este caso como los cuantos de estos campos.

De hecho todas las fuerzas fundamentales deben estar asociadas a una partícula elemental, el cuanto o bosón del campo correspondiente.

Los fermiones pueden describirse también en términos de campos, que aunque no se comportan en absoluto de manera clásica, pueden sin embargo asociarse, en cierto sentido, con fuerzas.

El Modelo Estándar

Todas las partículas elementales conocidas, salvo el gravitón, están descritas provisionalmente por la teoría del Modelo Estándar. Esta teoría parece estar en excelente acuerdo con la observación. Parece una buena teoría porque ha extraído mucha simplicidad de una gran variedad de fenómenos. Sin embargo, hay motivos por los que no puede ser la teoría definitiva de las partículas elementales:

Se han intentado formular sin éxito las llamadas teorías de gran unificación (GUT) e incluso Einstein llego a proponer unas ecuaciones para unificar electromagnetismo y gravedad. Einstein no tuvo éxito porque entre otras cosas ignoró:

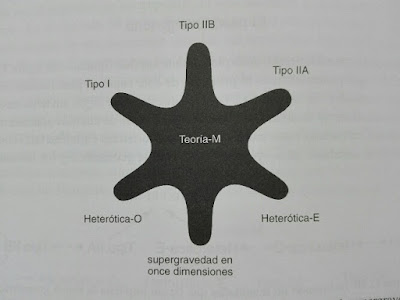

En la época en que se escribió este libro la teoría de supercuerdas parecía poseer las propiedades adecuadas para conseguir la unificación. En particular la teoría de supercuerdas heteróticas. Dos de ellas era que describia todas las partículas elementales y que predecía la existencia del gravitón, es decir, la gravedad einsteniana.

Es decir, incorpora la teoría de la Relatividad General y los demás campos dentro de una teoría cuántica de campos sin caer en los habituales problemas de los infinitos. Además la teoría no contiene, en principio, constantes arbitrarias.

Aunque llegáramos a descubrir la teoría del todo, esto no sería suficiente para predecir cualquier suceso en el universo porque necesitariamos conocer también las condiciones iniciales.

Aún conociendo las condiciones de contorno, no podríamos predecir el comportamiento del universo y todo lo que este contiene porque las leyes de la física son cuánticas, y la mecánica cuántica no es determinista, solo permite predecir probabilidades. Un ejemplo es la desintegración radiactiva, de la que solo se puede obtener el tiempo en que hay una probabilidad del 50% de que un átomo se desintegre. Tampoco es predecible la dirección en que saldrán las partículas resultantes de la desintegración.

Cada historia alternativa del universo depende de un numero inconcebiblemente grande de eventos cuyo resultados son aleatorios. La complejidad efectiva del universo solo recibe una pequeña contribución de las leyes fundamentales. El resto proviene de eventos con desenlace aleatorio cuyas consecuencias a largo plazo pueden tomar el carácter de una ley perteneciente a cualquier nivel salvo el más fundamental.

Una ley geológica, biológica o psicológica puede nacer de uno o más sucesos cuánticos amplificados, cada uno de lo cuales podría haber tenido un resultado diferente. Por eso es necesario estudiar con mayor profundidad el sentido de la mecánica cuántica, que nos enseña que el azar juega un papel fundamental en la descripción de la naturaleza.

A diferencia de la mecánica clásica que es determinista, la mecánica cuántica es probabilística. El dominio de la primera es el de los objetos masivos. La física clásica es solo una aproximación mientras que la mecánica cuántica es absolutamente correcta. No obstante, de la mecánica cuántica no tenemos una interpretación satisfactoria que nos permita comprender mejor como surge el dominio cuasiclásico de nuestra experiencia cotidiana a partir del carácter mecanocuántico subyacente de la naturaleza.

La primera interpretación consistía en que cuando se realiza un experimento muchas veces, las probabilidades de cada resultado tienden a ser las predichas por la mecánica cuántica. Sin embargo, si queremos aplicar la mecánica cuántica al universo completo no cabe la figura de un experimentador externo.

La interpretación moderna de la mecánica cuántica propone que el dominio cuasiclásico surge de las leyes de la mecánica cuántica, incluyendo las condiciones iniciales al comienzo de la expansión del universo. El pionero de la interpretación moderna fue Hugh Everett III, quien seguramente no empleó el vocabulario más acertado.

Esta nueva interpretación consiste en las múltiples historias alternativas del universo, todas ellas igual de válidas pero con probabilidades diferentes.

Entre los físicos que han realizado aportaciones a la interpretación moderna de la mecánica cuántica está Richard Feynman con la formulación en términos de historias a partir de un trabajo previo de Dirac. Esta formulación no solo pretende clarificar la interpretación moderna. Es también particularmente útil para describir la mecánica cuántica en interacción con la gravitación einsteniana, como ocurre con la cosmología cuántica. La geometría del espacio-tiempo se encuentra entonces sujeta a la indeterminación mecano-cuántica, y el método basado en las historias permite manejar particularmente bien esta situación.

Solo si existe decoherencia cuántica se pueden asignar probabilidades a las historias posibles. Solo si estas no interfieren entre sí, si son independientes, es decir, si son decoherentes.

Si no existe interferencia entre cada par de historias no detalladas (con no detalladas quiere decirse que se obvia toda la información que no influye en el suceso bajo estudio), entonces esas historias son decoherentes. En la práctica, la mecánica cuántica se aplica siempre a conjuntos de historias no detalladas decoherentes, y por eso es capaz de predecir probabilidades.

Por tanto la decoherencia cuántica es el mecanismo que hace que los términos de interferencia entre historias se anulen permitiendo la asignación de probabilidades.

La acumulación de electrones con el paso del tiempo en la pantalla detectora en el experimento de la doble rendija de Young formando patrones de interferencia son un efecto típicamente cuántico asociado a un estado puro (estado coherente). En tal caso es imposible saber por qué rendija pasó el electrón (o la probabilidad de que pasara por una u otra). En presencia de decoherencia cuántica el patrón de interferencia desaparecería y podríamos calcular la probabilidad de que el electrón pasara por cada una de las rendijas.

Se necesitan muchos datos de entrada para distinguir las regularidades de la aleatoriedad. Cuando un sistema complejo adaptativo recibe una sucesión de datos arbitrariamente larga puede buscar sistemáticamente regularidades, pero no hay un procedimiento exhaustivo para buscar todas las regularidades posibles.

Para buscar regularidades, un sistema complejo adaptativo divide los datos de entrada en partes comparables entre sí e investiga sus rasgos comunes. La información común a muchas partes o «información mútua», sirve para diagnosticar regularidades pero no para medir la complejidad efectiva.

Una vez se han identificado ciertas regularidades y se ha elaborado una concisa descripción de ellas, es la longitud de la descripción lo que mide la complejidad efectiva.

Para que la complejidad efectiva tenga un valor apreciable el contenido de la información algorítmica no debe ser ni demasiado bajo ni demasiado alto. El sistema no debe estar ni demasiado ordenado ni demasiado desordenado.

Diagrama que muestra a grandes rasgos cómo varía la complejidad efectiva máxima con el contenido de información algorítmica

La aleatoriedad pura tiene gran cantidad de información algorítmica y, sin embargo, complejidad efectiva nula. Por otro lado en una cadena de bits iguales a 1 tanto la información algorítmica como la complejidad efectiva son nulas (la descripcion «todo 1» es corta).

El contenido de información algorítmica es igual al contenido de información aparentemente regular más el contenido de información aparentemente estocástica.

En una secuencia de organismos cada vez menos sofisticados el aprendizaje individual tiene cada vez menos relevancia en comparación con los instintos acumulados en el transcurso de la evolución biológica. Pero la propia evolución biológica puede ser descrita a su vez como un sistema complejo adaptativo, incluso en los organismos más sencillos.

6. Bacterias que desarrollan resistencia a los fármacos

La complejidad efectiva de una bacteria, en el sentido de longitud de un esquema o descripción, está relacionada con la longitud del genoma. La longitud de la parte relevante del genoma proporciona una medida interna aproximada de la complejidad efectiva.

Pero esta idea es algo deficiente para comparar genomas y para establecer la complejidad de una especie. Por ejemplo, las diferencias entre los humanos y los primates son sutiles dando una complejidad efectiva similar pero los humanos somos una especie más avanzada.

7. La empresa científica

La empresa científica humana constituye una hermosa ilustración del concepto de sistema complejo adaptativo. Los esquemas son en este caso las teorías, y lo que tiene lugar en el mundo real es la confrontación entre la teoría y la observación.

Las nuevas teorías deben competir con las ya existentes, en parte en cuanto a coherencia y generalidad, pero en último término en cuanto a su capacidad de explicar las observaciones y predecir correctamente otras nuevas. De hecho, la misión del físico teórico no es idear teorías elegantes, sino explicar los resultados de las observaciones.

El proceso por el que las teorías resultan seleccionadas de acuerdo con la experiencia, coherencia y generalidad no es muy diferente de la evolución biológica.

Normalmente, las teorías surgen como resultado de multitud de observaciones. Una teoría se formula como un conjunto de principios simples, expresados de forma concisa como, por ejemplo, un conjunto de ecuaciones.

Por regla general, existen varias teorías en competencia que comparten estas características. La bondad de las predicciones de cada teoría, en consonancia con su verificación mediante observaciones, contribuye a determinar su supervivencia.

Las teorías en seria discordancia con las observaciones tienden a ser desplazadas por otras mejores, mientras que las teorías que predicen y explican satisfactoriamente las observaciones tienden a ser aceptadas y sirven de base para teorías futuras.

Falsabilidad e Intriga

El filósofo Karl Popper ha remarcado que el rasgo esencial de la ciencia es que sus teorías son falsables. Las teorías científicas hacen predicciones verificables mediante observaciones posteriores. Cuando una teoría resulta contradicha por observaciones fiables repetidas debe considerarse errónea. La posibilidad del error está siempre presente dando una intriga a toda actividad científica.

Los investigadores y científicos pueden verse influenciados por prejuicios, modas o el deseo de belleza y elegancia en sus teorías que los condicionen de antemano. Esto podría alterar la empresa científica. Pero el método científico se encarga de filtrar y eliminar a largo plazo las teorías que no describen la realidad.

Aunque el funcionamiento de la empresa científica puede ser complejo, el resultado final puede ser una clarificación general brillante, como en el caso de la formulación y verificación de una teoría unificadora.

Teorías que unifican y sintetizan

De vez en cuando, con una teoría se logra una notable síntesis, comprimiendo en un enunciado breve y elegante muchos fenómenos descritos anteriormente por separado y, en cierta forma, de manera inadecuada. Un excelente ejemplo son las Leyes de Maxwell.

Las ecuaciones de Maxwell describen en pocas líneas el comportamiento del electromagnetismo en cualquier parte del universo. Identifican con precisión las regularidades y las comprimen en unas pocas ecuaciones resultando un esquema descriptivo breve.

Ecuaciones de Maxwell en notación tensorial

Como la longitud del esquema es casi cero, ese es el valor de su complejidad efectiva. Es decir, las leyes del electromagnetismo son simples. Aunque a este esquema tuviéramos que añadir información de la notación o de los conceptos matemáticos utilizados, como el ámbito de validez de estas leyes es tan grande, la compresión conseguida seguiría siendo enorme.

La gravitación universal

La gravitación constituye otro caso extraordinario de ley universal. Newton elaboró la primera versión, refinada por Einstein en la Teoría General de la Relatividad. Más allá de predecir nuevas observaciones como la curvatura de los rayos luminosos, la Relatividad General aportó un cambio de paradigma o cambio conceptual. La Relatividad se fundamenta en el principio de equivalencia y, además, unifica el espacio y el tiempo y elimina la acción a distancia.

Ecuaciones de la teoría de la Relatividad General

De hecho, la competencia entre esquemas en el marco de la empresa científica no implica necesariamente que el anterior sea abandonado. Incluso puede ser utilizado con mucha mayor frecuencia que su más preciso sucesor por cuestiones de simplicidad como ocurre con la teoría newtoniana en el ámbito del Sistema Solar.

Igual que el electromagnetismo, la Relatividad General es un prodigio de compresión y, por tanto, una teoría simple.

8. El poder de la teoría

Por teoría entendemos un sistema coherente de leyes y principios, una explicación más o menos verificada o establecida que da cuenta de hechos o fenómenos conocidos.

La elaboración de una teoría puede conducir no solo a la identificación de regularidades presentes, sino también a una explicación plausible y a su posterior confirmación.

Pero a veces encontramos situaciones menos claras. Podemos hallar regularidades o predecirlas, descubrir que las predicciones se confirman y que no obstsnte pueda tratarse de un modelo cuya explicación última se nos escape. En este caso hablamos de una teoría empírica o fenomenológica.

9 ¿ Qué es lo fundamental?

El quark y el jaguar se encuentran prácticamente en los extremos opuestos de la escala de lo fundamental. La física de partículas elementales y la cosmología son las dos disciplinas científicas más básicas, mientras que el estudio de la materia viva altamente compleja es mucho menos básico.

En el caso de que las matemáticas sean consideradas una ciencia en lugar de solo un lenguaje (puede considerarse discutible porque no esta dedicada a la descripción de la naturaleza y sus leyes), sería la más básica de todas. Esto es así porque estudia todas aquellas estructuras que se dan en las teorías científicas y todas las que podrían haberse dado en otras teorías de mundos hipotéticos. Sería la ciencia de lo que es y de lo que podría haber sido o podría ser.

En cuanto a las otras disciplinas, ¿Qué es lo que hace que una ciencia sea más fundamental que otra? Podría sugerirse que la ciencia A es más fundamental que la B si:

- Las leyes de A abarcan los fenómenos y leyes de B.

- Las leyes de A son más generales que las de B.

Esto sería coherente con el razonamiento anterior para las matemáticas.

En el caso de la física y la química la primera sería más fundamental porque toda la química puede derivarse, aunque sea complejo, de la física. Un ejemplo sería la Electrodinámica Cuántica basada en la ecuación de Dirac, que explica gran parte de la química siempre que se consideren los núcleos de los átomos como partículas puntuales cargadas e inmóviles.

Para poder derivar las propiedades químicas de las teorías físicas fundamentales hay que aportar las condiciones químicas adecuadas sobre el caso concreto que se desea estudiar.

Sin embargo la química sigue siendo muy válida pues es la única posibilidad factible en los casos complejos imposibles de abordar con las leyes fundamentales de la física.

La explicación de una disciplina en términos de otra mas fundamental se suele denominar reducción. Este hecho también nos dice que las diferentes ciencias forman parte de una estructura conexa en las que unas pueden ser explicadas a través de otras. Esto implica que las diferentes ciencias tienen que estar relacionadas.

En cuanto a la biología, hay consenso en que esta se basa en las leyes de la física y la química, tal y como las leyes de la química surgen de las de la física, y en este sentido todos somos reduccionistas. Sin embargo, como ocurre con la química, sigue siendo muy provechoso estudiar la biología en sus propios términos y en su propio nivel.

Uno de los grandes desafíos de la ciencia contemporánea es el de explorar la mezcla de simplicidad y complejidad, regularidad y aleatoriedad, orden y desorden, escaleras arriba desde la física de partículas y la cosmología hasta el reino de los sistemas complejos adaptativos. Tenemos que aprender la manera como surgieron, a partir del orden, la simplicidad y la regularidad del Universo primigenio, las condiciones intermedias entre orden y desorden que han prevalecido en muchos lugares en épocas posteriores, y que han hecho posible entre otras cosas, la existencia de sistemas complejos adaptarivos como los seres vivos.

A este fin se debe examinar la física fundamental desde la perspectiva de la simplicidad y la complejidad, y preguntarnos sobre el papel desempeñado por la teoría unificada de las partículas elementales, las condiciones iniciales del Universo, la indeterminación de la mecánica cuántica y las incertidumbres de la teoría clásica del caos, en la producción de los patrones de regularidad y aleatoriedad universales que han permitido la evolución de los sistemas complejos adaptativos.

Segunda Parte: El Universo Cuántico

10. Simplicidad y aleatoriedad en el universo cuántico

Las leyes fundamentales están sujetas a los principios de la Mecánica Cuántica. Esta teoría es uno de los mayores descubrimientos hechos por el hombre, pero es también uno de los más difíciles de comprender por la mente humana porque va contra nuestra intuición.

El universo consta de materia compuesta de partículas elementales como los electrones y los fotones. Las partículas carecen de individualidad (cada electrón del universo es idéntico a cualquier otro y todos los fotones son intercambiables). Sin embargo cada partícula puede ocupar uno entre un número infinito de estados cuánticos.

Hay dos grandes grupos de partículas: los fermiones que obedecen el principio de exclusión de Pauli, y los bosones, que tienen tendencia a ocupar el mismo estado al mismo tiempo.

Por eso los bosones pueden aumentar su densidad hasta tener un comportamiento prácticamente clásico, como el de los campos electromagnéticos y gravitatorio. Las partículas bosónicas pueden considerarse en este caso como los cuantos de estos campos.

De hecho todas las fuerzas fundamentales deben estar asociadas a una partícula elemental, el cuanto o bosón del campo correspondiente.

Los fermiones pueden describirse también en términos de campos, que aunque no se comportan en absoluto de manera clásica, pueden sin embargo asociarse, en cierto sentido, con fuerzas.

El Modelo Estándar

Todas las partículas elementales conocidas, salvo el gravitón, están descritas provisionalmente por la teoría del Modelo Estándar. Esta teoría parece estar en excelente acuerdo con la observación. Parece una buena teoría porque ha extraído mucha simplicidad de una gran variedad de fenómenos. Sin embargo, hay motivos por los que no puede ser la teoría definitiva de las partículas elementales:

- Las fuerzas se tratan como diferentes y no unificadas a pesar de que deberían ser muy similares y aparecer como diferentes manifestaciones de una misma fuerza subyacente.

- El modelo no es suficientemente simple. Distingue más de sesenta clases de partículas elementales sin explicar el motivo de tanta variedad.

- Contiene más de una docena de constantes arbitrarias no impuestas por la teoría que describen las masas de las partículas y las interacciones entre ellas.

- La gravitación no está incluida en el modelo y todos los intentos para incorporarla topan con dificultades desastrosas e infinitos.

Se han intentado formular sin éxito las llamadas teorías de gran unificación (GUT) e incluso Einstein llego a proponer unas ecuaciones para unificar electromagnetismo y gravedad. Einstein no tuvo éxito porque entre otras cosas ignoró:

- La existencia de otros campos además del gravitatorio y del electromagnético.

- La necesidad de incluir no solo los campos que la teoría cuántica revela compuestos de bosones como el fotón y el gravitón, sino también los fermiones.

- La necesidad de construir una teoría unificada dentro del marco de la mecánica cuántica, que Einstein nunca aceptó.

En la época en que se escribió este libro la teoría de supercuerdas parecía poseer las propiedades adecuadas para conseguir la unificación. En particular la teoría de supercuerdas heteróticas. Dos de ellas era que describia todas las partículas elementales y que predecía la existencia del gravitón, es decir, la gravedad einsteniana.

Es decir, incorpora la teoría de la Relatividad General y los demás campos dentro de una teoría cuántica de campos sin caer en los habituales problemas de los infinitos. Además la teoría no contiene, en principio, constantes arbitrarias.

Aunque llegáramos a descubrir la teoría del todo, esto no sería suficiente para predecir cualquier suceso en el universo porque necesitariamos conocer también las condiciones iniciales.

Aún conociendo las condiciones de contorno, no podríamos predecir el comportamiento del universo y todo lo que este contiene porque las leyes de la física son cuánticas, y la mecánica cuántica no es determinista, solo permite predecir probabilidades. Un ejemplo es la desintegración radiactiva, de la que solo se puede obtener el tiempo en que hay una probabilidad del 50% de que un átomo se desintegre. Tampoco es predecible la dirección en que saldrán las partículas resultantes de la desintegración.

Cada historia alternativa del universo depende de un numero inconcebiblemente grande de eventos cuyo resultados son aleatorios. La complejidad efectiva del universo solo recibe una pequeña contribución de las leyes fundamentales. El resto proviene de eventos con desenlace aleatorio cuyas consecuencias a largo plazo pueden tomar el carácter de una ley perteneciente a cualquier nivel salvo el más fundamental.

Una ley geológica, biológica o psicológica puede nacer de uno o más sucesos cuánticos amplificados, cada uno de lo cuales podría haber tenido un resultado diferente. Por eso es necesario estudiar con mayor profundidad el sentido de la mecánica cuántica, que nos enseña que el azar juega un papel fundamental en la descripción de la naturaleza.

11. Una versión contemporánea de la mecánica cuántica y su aproximación clásica

A diferencia de la mecánica clásica que es determinista, la mecánica cuántica es probabilística. El dominio de la primera es el de los objetos masivos. La física clásica es solo una aproximación mientras que la mecánica cuántica es absolutamente correcta. No obstante, de la mecánica cuántica no tenemos una interpretación satisfactoria que nos permita comprender mejor como surge el dominio cuasiclásico de nuestra experiencia cotidiana a partir del carácter mecanocuántico subyacente de la naturaleza.

La primera interpretación consistía en que cuando se realiza un experimento muchas veces, las probabilidades de cada resultado tienden a ser las predichas por la mecánica cuántica. Sin embargo, si queremos aplicar la mecánica cuántica al universo completo no cabe la figura de un experimentador externo.

La interpretación moderna de la mecánica cuántica propone que el dominio cuasiclásico surge de las leyes de la mecánica cuántica, incluyendo las condiciones iniciales al comienzo de la expansión del universo. El pionero de la interpretación moderna fue Hugh Everett III, quien seguramente no empleó el vocabulario más acertado.

Esta nueva interpretación consiste en las múltiples historias alternativas del universo, todas ellas igual de válidas pero con probabilidades diferentes.

Entre los físicos que han realizado aportaciones a la interpretación moderna de la mecánica cuántica está Richard Feynman con la formulación en términos de historias a partir de un trabajo previo de Dirac. Esta formulación no solo pretende clarificar la interpretación moderna. Es también particularmente útil para describir la mecánica cuántica en interacción con la gravitación einsteniana, como ocurre con la cosmología cuántica. La geometría del espacio-tiempo se encuentra entonces sujeta a la indeterminación mecano-cuántica, y el método basado en las historias permite manejar particularmente bien esta situación.

Solo si existe decoherencia cuántica se pueden asignar probabilidades a las historias posibles. Solo si estas no interfieren entre sí, si son independientes, es decir, si son decoherentes.

Si no existe interferencia entre cada par de historias no detalladas (con no detalladas quiere decirse que se obvia toda la información que no influye en el suceso bajo estudio), entonces esas historias son decoherentes. En la práctica, la mecánica cuántica se aplica siempre a conjuntos de historias no detalladas decoherentes, y por eso es capaz de predecir probabilidades.

Por tanto la decoherencia cuántica es el mecanismo que hace que los términos de interferencia entre historias se anulen permitiendo la asignación de probabilidades.

La acumulación de electrones con el paso del tiempo en la pantalla detectora en el experimento de la doble rendija de Young formando patrones de interferencia son un efecto típicamente cuántico asociado a un estado puro (estado coherente). En tal caso es imposible saber por qué rendija pasó el electrón (o la probabilidad de que pasara por una u otra). En presencia de decoherencia cuántica el patrón de interferencia desaparecería y podríamos calcular la probabilidad de que el electrón pasara por cada una de las rendijas.

Patrón de interferencia en el experimento de la doble rendija debido a la coherencia cuántica

La decoherencia cuántica es el término aceptado y utilizado en mecánica cuántica para explicar cómo un estado cuántico entrelazado puede dar lugar a un estado físico clásico (no entrelazado). En otras palabras, cómo un sistema físico, bajo ciertas condiciones específicas, deja de exhibir efectos cuánticos y pasa a exhibir un comportamiento típicamente clásico, sin los efectos contraintuitivos típicos de la mecánica cuántica.

El nombre procede del hecho técnico de que la decoherencia se manifiesta matemáticamente por la pérdida de coherencia de la fase compleja relativa de las combinaciones lineales que definen el estado. Así la decoherencia cuántica explicaría por qué a grandes escalas la física clásica que ignora los efectos cuánticos constituye una buena explicación del comportamiento del mundo.

En el experimento de la doble rendija las historias se interfieren (no hay decoherencia) y no se les pueden asignar probabilidades. Carece de sentido entonces preguntarse que rendija atravesó el electrón.

En el caso de la órbita de un cuerpo en el Sistema Solar, todo aquello que influye en la órbita para cada historia posible se va sumando o promediando (como todos los fotones del Fondo Cósmico de Microondas que chocan con él) y aquello que no tiene un efecto neto se acaba cancelando resultando la órbita final.

Estas cancelaciones se deben en parte a la masa y tamaño del cuerpo, mucho mayor que las partículas elementales, que hace que todas las interacciones cuánticas aleatorias se acaben promediando y anulándose en media.

Si el caso de estudio interacciona con el resto del universo, hay muchas oportunidades para la decoherencia cuántica. En el caso clásico suele suceder esto y por eso ningún objeto cuasiclásico real puede mostrar un comportamiento cuántico, porque el tamaño grande de los objetos hará inevitable su interacción con el resto del universo, lo que conducirá a la decoherencia de las posibles alternativas.

12. Mecánica Cuántica y verborrea

Como la mecánica cuántica solo predice probabilidades, a veces se piensa que esta teoría permite que ocurra casi cualquier cosa. Sin embargo, si se descartan los sucesos con probabilidades ínfimas, entonces los sucesos imposibles en mecánica clásica también lo son en mecánica cuántica.

Por otro lado la publicación del teorema de Bell basado en un experimento de dos fotones que se mueven en direcciones opuestas ha hecho pensar a algunos erróneamente que la mecánica cuántica permite la comunicación a velocidad mayor que la de la luz.

Estos prejuicios hacia la mecánica cuántica tienen su origen en parte por las objeciones de Einstein, a pesar que fue el primero en tomar en serio la hipótesis de Planck de la cuantización de la energía en su explicación del efecto fotoeléctrico.

En 1930 en la Conferencia Solvay y en 1935 con el experimento mental EPR, Einstein intentó invalidar la mecánica cuántica sin conseguirlo.

Otros físicos también propusieron sustituir la mecánica cuántica por una teoría determinista pero en la que hubiera presente un gran número de variables ocultas que provocarían una cierta indeterminación en las medidas.

Otro experimento ideado sin éxito para mostrar posibles inconsistencias en la mecánica cuántica fue el experimento EPRB en el que se trataba de medir la polarización de dos fotones que viajan en direcciones opuestas generados por la desintegración de una partícula que está inicialmente en reposo y que no tiene espín.

Aunque los experimentos han mostrado una aparente complejidad por el descubrimiento del gran número de partículas y sus interacciones, los progresos en física teórica revelan una gran simplicidad subyacente. Quizás se llegué a descubrir un principio único que pueda predecir la existencia de la diversidad de partículas elementales observadas.

13. Quarks y todo lo demás: el modelo estándar

Toda teoría sobre las partículas elementales se desarrrolla dentro del marco de la teoría cuántica de campos, que incluye tanto el modelo estándar como la teoría de supercuerdas. Está basada en tres supuestos fundamentales:

- La validez de la mecánica cuántica.

- La validez del principio de relatividad de Einstein.

- La localidad, es decir, todas las fuerzas fundamentales surgen de procesos locales y no de la acción a distancia. Estos procesos locales incluyen la emisión y absorción de partículas.

Electrodinámica Cuántica

Es el primer ejemplo de teoría cuántica de campos satisfactoria cuyo origen está en la ecuación relativista del electrón publicada por Dirac en 1928. Es la teoría del electrón y el fotón. En el marco de esta teoría, la fuerza electromagnética entre dos electrones surge de la emisión de un fotón por una de las partículas y su absorción por la otra.

La ecuación de Dirac del electrón

Esta emisión y absorción podría parecer que viola el principio de conservación de la energía o el momento. Pero en mecánica cuántica esto puede suceder dentro de los límites del principio de Incertidumbre.

El Principio de Incertidumbre de Heisenberg

El sistema puede tomar prestada por un momento un poco de energía para permitir que el primer electrón emita un fotón, energía que será devuelta cuando el otro electrón lo absorba. Esto se conoce como un intercambio virtual de un fotón entre dos electrones.

En cualquier teoría cuántica de campos pueden usarse los diagramas de Feynman que simplifican los cálculos de probabilidades.

Diagrama de Feynman en que un electrón se aniquila con un positrón. El fotón resultante se transforma posteriormente en un nuevo par electrón-positrón

La teoría cuántica de campos implica una simetría fundamental entre las partículas elementales y sus antipartículas. Para cada partícula hay una antipartícula correspondiente con su misma masa pero carga opuesta, que se comporta como la partícula pero moviéndose hacía atrás en el tiempo y en el espacio. La antipartícula de la antipartícula es la propia partícula. La antipartícula del electrón es el positrón y del fotón es ella misma.

El Modelo Estándar puede considerarse como una generalización de la Electrodinámica Cuàntica. El par electrón-positrón se suplementa con otros muchos pares fermiónicos, y los fotones con otros bosones gauge. Así como el fotón es el portador de la fuerza electromagnética, los otros cuantos son los mediadores de las otras fuerzas fundamentales.

Quarks

Los compañeros del electrón en el átomo, el protón y el neutrón, son partículas compuestas por tres quarks cada una. En el caso del protón dos quarks up y uno down. Y el neutrón agrupa dos quarks down y uno up. El quark up tiene carga 2/3 y el quark down -1/3 para así obtener la carga +1 del protón y la carga neutra del neutrón.

Se dice que up y down son diferentes sabores de quark. Los quarks tienen además otra propiedad aún más importante llamada color. Para formar un protón o un neutrón los tres quarks deben tener colores diferentes (rojo, verdela y azul) de manera que estos sean blancos.

Quarks confinados

Los quarks tienen la notable propiedad de estar permanentemente atrapados dentro de partículas blancas como el protón y el neutrón. Solo las partículas blancas son directamente observables en el laboratorio. Solo en su interior pueden existir objetos coloreados. De la misma forma, la carga eléctrica de una partícula observable es siempre un número entero, y las partículas con carga fraccionaria sólo pueden existir en su interior.

Gluones coloreados

Los quarks interaccionan entre sí por una fuerza que surge del intercambio virtual de gluones. Estos bosones son indiferentes al sabor pero muy sensibles al color. Para ellos, el color es similar a lo que es la carga eléctrica para los fotones.

La triple naturaleza del color requiere de los gluones una propiedad que no comparten con el fotón: existen diferentes gluones para las diferentes interacciones de color.

Por ejemplo, un quark rojo se convierte en azul emitiendo un gluon virtual rojo-azul, el cual es absorbido por un quark azul que se convierte a su vez en rojo. La antipartícula del gluón rojo-azul es un gluón azul-rojo.

Comparación entre la QCD y la QED. Los quarks y antiquarks se asocian con el fotón a través de su carga eléctrica, pero el positrón y el electrón no se asocian con los gluones

Cromodinámica Cuántica

Es la teoría cuántica de campos definida para quarks y gluones.

Intercambio de fotones virtuales y gluones virtuales

La fuente de la fuerza electromagnética son las cargas eléctricas. En el caso de la fuerza de color, esta surge de las cargas de color.

No obstante existe una diferencia crucial entre ambas teorías: el fotón es eléctricamente neutro mientras que los gluones estan coloreados. Esto hace que los gluones interactúen entre sí de una manera imposible para los fotones, lo que origina términos en las ecuaciones de la QCD que no tienen analogo en la QED.

La lagrangiana de la Electrodinámica Cuántica es una ecuación con cuatro términos. Los dos primeros corresponden a la ecuación de Dirac, el tercero es el de interacción entre el electrón y el fotón (consecuencia de la simetría gauge) y el cuarto es el de la propagación del fotón en ausencia de fuentes (onda electromagnética)

La fuerza de color se comporta de manera muy distinta a la electromagnética o cualquier otra fuerza conocida: no se desvanece a largas distancias. Esta propiedad explica el confinamiento de quarks, antiquarks y gluones en objetos blancos como protones y neutrones. Otra propiedad de esta fuerza es la libertad asintótica, que hace que su intensidad se reduzca a medida que la distancia entre quarks se reduce, anulándose para distancias tendiendo asintóticamente a cero.

La simplicidad revelada por la QCD

La fuerza nuclear que liga (pero no confina) a protones y neutrones en el núcleo no es fundamental, sino que surge como un efecto secundario de la fuerza de color, que a su vez procede de la interaccion entre quarks y gluones. Esto es similar a lo que ocurre con las fuerzas entre átomos o moléculas. Estas fuerzas tampoco son fundamentales, sino una consecuencia indirecta de la cuantización de la fuerza electromagnética.

Además del protón y del neutrón hay multitud de partículas blancas (como el barión lambda) que gracias a la QCD son explicadas como combinaciones de quarks, antiquarks y gluones. La QCD ha revelado así una simplicidad subyacente a una complejidad aparente.

Los bariones protón, neutrón y lambda formados por tres quarks y los mesones (formados por un par quark-antiquark) son ejemplos de las dos familias de hadrones

Por otra parte, todas las partículas formadas por quarks interaccionan entre sí a través de la interacción fuerte, que incluye la fuerza nuclear. Esta interacción es consecuencia indirecta de la interacción fundamental quark-gluón.

Fuerzas entre quarks a partir del intercambio de dos gluones virtuales

Electrón y neutrino electrónico: La fuerza débil

Además de los quarks, las otras partículas importantes que forman la materia son los electrones. Estos no poseen color pero sí sabor. El electrón tiene como compañero el neutrino electrónico, que además de no tener color tampoco tiene carga eléctrica. Unido a su minúscula masa, es una partícula que apenas interacciona.

La mayoria de los neutrinos que atraviesan la Tierra se generan en las reacciones termonucleares, o de fusión nuclear, en el interior del Sol a través de la fuerza débil.

La desintegración radiactiva beta está gobernada por la fuerza débil. En ella un neutrón se convierte en un protón, un electrón y un antineutrino

En estas reacciones un electrón se convierte en un neutrino electrónico, mientras que un protón se convierte en un neutrón. Y a la inversa, un neutrino electrónico se convierte en un electrón, al tiempo que un neutrón se convierte en un protón.

Un electrón se transforma en un neutrino electrónico a la vez que un quark up se convierte en un quark down. Dos versiones del mismo diagrama de Feynman

Sin embargo, estos no son procesos básicos porque ni el neutrón ni el protón no son procesos básicos. Los auténticos procesos en los que intervienen los quarks son:

1) Un electrón se transforma en un neutrino electrónico mientras que un quark up se convierte en un quark down.

2) Un neutrino electrónico se convierte en un electrón, al tiempo que un quark down pasa a ser un quark up.

En estas reacciones se produce un cambio de sabor tanto en el electrón que se convierte en un neutrino electrónico (y viceversa) como del quark up que se convierte en un quark down (y viceversa).

Como en toda interacción descrita por una teoría cuántica de campos, esta es mediada por un cuanto. En estos casos son los bosones gauge débiles W±.

Dinámica cuántica del sabor y corrientes neutras

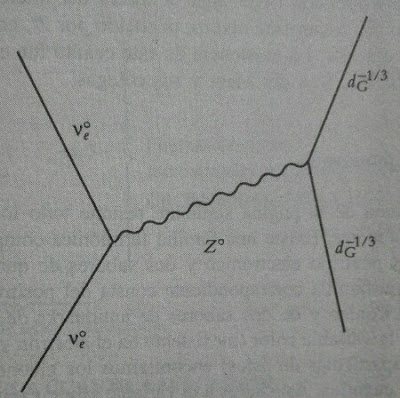

Tanto el electromagnetismo como las interacciones débiles pueden considerarse fuerzas de sabor. Por ello no es de extrañar que se unificaran bajo la teoría electrodébil. Uno de los primeros éxitos de esta teoría fue predecir el bosón gauge débil eléctricamente neutro Z°, mediador de una fuerza de sabor que causa la dispersión de los neutrinos electrónicos por parte de protones y neutrones sin cambio de sabor.

Familias de fermiones

Los quarks, electrones, neutrinos y sus antipartículas se agrupan en tres familias. Cada una de ellas con un electrón o partícula análoga a él (muón y tau), un neutrino y dos sabores de quarks de tres colores.

Las partículas principales del modelo estándar. Los quarks y los leptones (fermiones) se agrupan en tres familias

Asociados al color encontramos los gluones de la QCD y, al sabor, estan los cuatro bosones gauge de la interacción electrodébil: el fotón, los W± y Z°.

En principio no hay más familias fermiónicas que estas tres. Las predicciones de la desintegración de Z° comprobadas experimentalmente permiten su desintegración en tres clases de pares neutrino-antineutrino, correspondientes precisamente a los neutrinos electrónico, muónico y tauónico. No hay lugar para una cuarta clase de neutrino, a menos que tenga una masa gigantesca.

Dispersión de un neutrino electrónico en un quark down

Con las tres familias de fermiones, sus antipartículas y los bosones gauge de las interacciones electromagnética, débil y fuerte, el modelo estándar sigue siendo una extensión trivial de la QED. Hemos añadido fermiones al electrón y bosones al fotón. Con esta diversidad de partículas aparece cierta complejidad en el modelo estándar pero aún no hemos llegado a su nivel fundamental en el que se revela la simplicidad subyacente de la teoría.

La aproximación de masa nula

Si consideramos la aproximación de que todas las partículas tienen mada nula (ello implica que se mueven a la velocidad de la luz y no pueden estar nunca en reposo), entonces se manifiesta la similitud entre los bosones de las tres interacciones. La teoría electrodébil y la QCD tienen una estructura matemática semejante, perteneciendo ambas a las llamadas teorías gauge o de Yang-Mills.

Cuando también se asigna masa nula a los fermiones, aparecen muchas simetrías entre las tres familias, mostrando idénticas propiedades.

Sin embargo esto no se da en la realidad con lo que necesitamos un mecanismo que asigne la gran variedad de masas de las partículas conocidas sin eliminar las simétrias.

Ruptura espontánea de simetría

La ruptura espontánea de simetría rompe la aproximación de masa nula mediante la existencia de un nuevo bosón: el bosón de Higgs.

La esencia de este mecanismo es que las ecuaciones con una simetría determinada pueden tener soluciones que violen individualmente esa simetría, aunque el conjunto de todas las soluciones sea simétrico.

Por ejemplo si tenemos un lápiz en equilibrio (inestable) vertical sobre una mesa, el sistema tiene simetría pues el lápiz puede caer potencialmente en cualquier dirección. En el momento de caer, la simetría se rompe porque la dirección en la que el lápiz cae ya no es equivalente al resto.

Igual sucede con un conjunto de imanes orientados aleatoriamente (existe simetría pues todas las direcciones son equivalentes). En el momento en que dos imanes se orientan espontaneamente en la misma dirección poco a poco todos los imanes se orientan paralelamente quedando todos apuntando en la misma dirección y rompiendo la simetría.

La mayor virtud de este mecanismo es que permite que los fermiones y los bosones gauge débiles adquieran masa no nula evitando los infinitos en la teoría electrodébil.

Lagrangiana del modelo estándar de partículas donde las dos últimas líneas se corresponden con el mecanismo de Higgs y la ruptura espontánea de simetría

Ruptura de la simetría temporal

El mecanismo de Higgs puede ser también responsable de la pequeña desviación de la simetría de inversión temporal observada en la física de partículas. Esta ruptura sería otro ejemplo de ecuación simétrica con un conjunto simétrico de soluciones asimétricas, de las cuales solo una se observa en la naturaleza. En este caso habría dos soluciones, que difieren en el sentido del tiempo.

Ruptura de la simetría materia-antimateria

Si se combinan las operaciones matemáticas que intercambian el sentido del tiempo, con la que intercambia derecha e izquierda y con la que intercambia materia y antimateria, la operación resultante, llamada simetría CPT es una simetría exacta de la teoría cuántica de campos.

Por ello la ruptura espontánea de la simetría temporal supone también la ruptura de simetría entre materia y antimateria. ¿Podría esta ruptura ser la responsable de que apenas haya antimateria en nuestro universo?

Espín

Una diferencia importante entre el bosón de Higgs y los fermiones y bosones conocidos previamente es que debe tener espín nulo a diiferencia de los fermiones que tienen espín semientero (los del modelo estandar ½) o de los bosones, que tienen espín entero.

¿Por qué hay tantas partículas elementales?

La enorme multiplicidad de partículas elementales quedó explicada tras el descubrimiento de que eran partículas compuestas a partir de quarks, antiquarks y gluones. Aun así el conjunto de estos 3 elementos es bastante numeroso y, además, tenemos los fermiones y sus antipartículas, más los bosones gauge.

Si calculamos el número total tenemos:

- 18 quarks (3 colores y 6 sabores) y sus antipartículas.

- 3 partículas similares al electrón y 3 neutrinos y sus antipartículas.

- 8 gluones.

- El fotón y los tres bosones gauge débiles.

- El bosón de Higgs.

Parece una locura suponer que las leyes básicas de la naturaleza puedan basarse en un conjunto de objetos fundamentales tan grande y heterogéneo. La solución a este rompecabezas ha de pasar por incorporar el modelo estándar en una teoría unificada de todas las partículas elementales y de sus interacciones.

Igual que el modelo estándar, esta teoría unificada debe ser comprobable independientemente, es decir, debe hacer predicciones verificables mediante la observación. ¿Como se podrían generar estás partículas a partir de un modelo más simple?

Hay tres modos:

- Suponer que las partículas elementales son entes compuestos por un número menor de constituyentes fundamentales.

- La existencia de objetos cada vez mas fundamentales sin fin.

- La existencia de una teoría simple en la base del sistema de partículas elementales que admita un numero infinito de estas, siendo accesible a la comprobación experimental dentro de las energías actualmente alcanzables. En esta categoría estaría la teoría de supercuerdas.

14. La teoría de supercuerdas

La teoría de supercuerdas heteróticas, es una buena candidata a teoría unificada. Pero para ello debemos obtener predicciones correctas comprobables mediante experimentos.

Las diferentes teorías de supercuerdas son en el fondo soluciones particulares de una teoría más profunda llamada teoría M

Un rasgo llamativo de esta teoría es la aparición de la energía o masa de Planck, de valor elevadísimo, cerca del cual en esta teoría se manifiesta la unificación de las interacciones.

Masa de Planck

Energía de Planck obtenida a partir de la masa de Planck y la equivalencia entre masa y energía de la Relatividad Especial

Pero la escala de la energía de Planck es enorme comparada con las energías accesibles experimentalmente. Así pues las partículas estudiables experimentalmente por tener masas lo suficientemente pequeñas pertenecen al sector de masa baja de la teoría de supercuerdas.

Experimento CMS del Gran Colisionador de Hadrones del CERN donde se podría comprobar experimentalmente el sector de masa baja de la teoría de cuerdas

Al sector de masa baja de la teoría pertenece el modelo estándar con todas sus partículas. El gravitón, de masa nula, también pertenece obviamente.

Renormalización del Modelo Estándar

El modelo estándar se distingue de la teoría de la gravitación por una propiedad extraordinaria llamada renormalización. Esto significa que puede separarse de la teoría unificada sin que aparezcan infinitos.

El precio a pagar es la aparición de más de una docena de parámetros arbitrarios, que no pueden calcularse teóricamente y deben ser determinados experimentalmente.

Estos parámetros representan la dependencia del modelo del resto de la teoría fundamental unificada, incluyendo el infinito conjunto de partículas de masa alta.

La comparación con la experiencia no es imposible. A pesar de la elevada energía de la escala de Planck, hay bastantes maneras de confrontar la teoría con los resultados experimentales:

- Para comenzar, la teoría de supercuerdas predice en el límite adecuado la teoría de la Relatividad General de Einstein. La incorporación de la Relatividad General dentro de una teoría cuántica de campos sin que aparezcan infinitos es un gran logro.

- El siguiente reto es determinar si la teoría de supercuerdas puede predecir, con alguna aproximación, el modelo estándar y los valores arbitrarios de sus constantes.

- El sector de masa baja de la teoría contiene nuevas partículas adicionales, cuyas propiedades son predecibles y comprobables experimentalmente.

- La teoría de supercuerdas puede tener consecuencias cosmológicas verificables por observación astronómica.

Unidades naturales

La energía de Planck es la unidad básica de energía derivada a partir de las constantes universales de la naturaleza:

- La velocidad de la luz en el vacío.

- La constante de Planck.

- La constante de gravitación universal.

Multiplicando y dividiendo potencias adecuadas de las tres constantes universales puede construirse la unidad fundamental de cualquier magnitud física, como longitud, tiempo, energía, masa o fuerza.

La masa de las partículas y la unidad básica

Las masas de las partículas elementales son extremadamente pequeñas en comparación con la unidad fundamental sin que sepamos el por qué. Una conjetura podría ser admitir que todas las partículas del sector de masa baja tienen masa nula y que las pequeñas masas no nulas son consecuencia de las correcciones que introduce la ruptura espontánea de simetría del mecanismo de Higgs.

El significado del termino supercuerda

El término cuerda indica que la teoría describe las partículas en términos de pequeños lazos de una longitud de Planck que a energías normales parecen partículas puntuales.

Las cuerdas son filamentos de energía de longitud en la escala de Planck cuyos modos de vibración dan lugar a las diferentes partículas

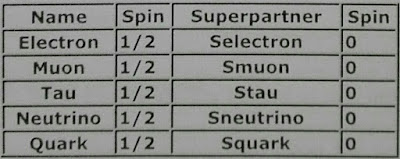

El prefijo super indica que la teoría es aproximadamente supersimétrica, es decir, que cada fermión tiene asociado un boson correspondiente cuyo espín difiere en un valor ½ y viceversa.

Los bosones y sus posibles compañeras supersimétricas

Los fermiones, las partículas que constituyen la materia, y sus posibles supercompañeras

Si esta supersimetría fuera exacta, cada fermión tendría precisamente la misma masa que su bosón asociado. Sin embargo la supersimetría se rompe provocando masas diferentes para cada pareja supersimétrica fermión-bosón.

Podría ser que en la escala de la energía de Planck la supersimetría fuera exacta y que al descender la temperatura, esta se rompiera.

En el Big Bang la energía sería comparable a la de Planck con lo que podría encontrarse alguna evidencia cósmica remanente que pudiera probar la validez de la teoría de cuerdas.

Multiplicidad aparente de soluciones

Además de las elevadas energías necesarias para verificar la teoría de supercuerdas no alcanzables en los experimentos, otro motivo que dificulta la verificabilidad de la teoría es el descubrimiento de numerosas soluciones aproximadas de las ecuaciones de la teoría de supercuerdas heteróticas. A este conjunto elevado de soluciones se le llama paisaje de soluciones.

Cada uno de los puntos del paisaje es una solución de la teoría con unas partículas determinadas y unas constantes físicas universales concretas.

Puesto que hay muchísimas soluciones, no es descabellado pensar que alguna sea compatible con el mundo en que vivimos. Pero, ¿Qué hacemos con el resto de soluciones? Hay varias respuestas:

- La teoría es equivocada.

- Los problemas aparecidos se deben exclusivamente a la aproximación, y cuando esta sea mejorada todas las soluciones menos una careceran de sentido y podrán descartarse.

Acción

Esta magnitud es útil y una manera elegante de formular la mecánica clásica gracias al principio de mínima acción. Pero con la llegada de la mecánica cuántica paso de ser útil a esencial. Sus unidades son de energía por tiempo, igual que la constante de Planck.

Definición de la magnitud física llamada acción como la integral temporal del lagrangiano

El principio de mínima acción nos dice que las ecuaciones de movimiento surgen de minimizar una magnitud física llamada acción

Las ecuaciones de Euler-Lagrange obtenidas mediante el cálculo de variaciones proporcionan el lagrangiano L que minimiza la acción

El valor de la acción determina la probabilidad de cada una de las historias posibles para un suceso en mecánica cuántica.

Formulación de la integral de camino o de suma de historias de la mecánica cuántica propuesta por Richard Feynman

Según esta formulación de las historias posibles, la probabilidad de que una partícula cuántica vaya de (x,t) a (x',t') se calcula no considerando un único camino como en la mecánica clásica, sino los infinitos caminos que unen (x,t) con (x',t').

Cada camino tiene una contribución a la probabilidad total que es proporcional a eiLdt/2πh, siendo Ldt=S su acción correspondiente de forma que se suman las contribuciones de los infinitos caminos posibles y se eleva al cuadrado dicha suma para obtener la probabilidad total.

Por eso sería deseable encontrar una fórmula para la acción en términos de la teoría de cuerdas porque, además de proporcionarnos las ecuaciones de la teoría, nos permitiría identificar más fácilmente sus simetrías. Minimizando la acción podríamos obtener las ecuaciones de la teoría.

Sin embargo lo único que se ha conseguido hasta ahora es expresar la acción como una serie infinita que aún no se ha conseguido sumar. Solo se ha logrado demostrar la convergencia o finitud de los primeros términos.

Podría ser que nos falte descubrir un principio que nos permita escribir la fórmula de la acción de manera directa sin recurrir a series infinitas.

Por ejemplo, las ecuaciones de la Relatividad General podrían construirse por la fuerza bruta mediante el concepto de acción sin necesidad del principio de equivalencia. Pero entonces la acción viene expresada por una suma infinita cuya suma era virtualmente imposible en ausencia de la perspectiva geométrica del principio de equivalencia.

¿Universos múltiples?

La cosmología cuántica comentada hasta aquí se ha referido a historias alternativas del universo. Sin embargo podría ser que estas historias correspondieran a universos independientes. generando un multiverso.

Estos universos podrían ser de tamaño comparable al nuestro pero cuyo contacto mutuo, si es que existe, fuera muy limitado, tanto en el pasado remoto como en el futuro lejano. Los universos serían como las burbujas dentro del multiverso, que se separaron hace mucho tiempo.

Cada universo burbuja podría estar caracterizado por una de las soluciones de la teoría de supercuerdas. Aquella solución que más apareciera, podría considerarse la más probable.

15. La flecha del tiempo

La razón última de la unidireccionalidad del tiempo, es que el universo se encontraba en un estado muy ordenado en sus inicios. Las condiciones iniciales eran de un gran orden y baja entropía.

La asimetría temporal es parte del principio de causalidad física, que afirma que los efectos siguen a las causas.

Además de la causalidad, otra flecha que marca la diferencia entre pasado y futuro es la tendencia de la entropía a aumentar (segunda ley de la termodinámica).

No solo la flecha del tiempo causal apunta hacia el futuro, sino también la flecha termodinámica, que apunta del orden al desorden.

Finalmente sobre la cuarta parte me gustaría reflejar un comentario del autor que me parece muy acertado.

Cuarta Parte: Diversidad y Sostenibilidad

Los cerca de 4000 millones de años de evolución biológica en la Tierra han producido, mediante ensayo y error, una gigantesca cantidad de informacion acerca de los modos de vida de los organismos en el seno de la biosfera.

De modo similar, a lo largo de más de 50.000 años, los seres humanos modernos han desarrollado una extraordinaria cantidad de información sobre maneras de vivirla, en interacción mutua y con el resto de la biosfera. Tanto la diversidad biológica como cultural se encuentran ahora severamente amenazadas, y trabajar para su preservación es una tarea de importancia capital.

Pero la preservación de la diversidad cultural presenta algunas paradojas y conflictos con otras metas. Uno de los desafíos más difíciles es reconciliar esta diversidad con la reciente necesidad de unidad entre los pueblos, que se enfrentan ahora con problemas comunes a escala global.

Otro es el representado por la hostilidad que presentan algunas culturas localistas hacia la cultura secular científica y universalizante; precisamente de estas culturas salen muchos de los más vigorosos defensores de la preservación de la diversidad cultural.

La conservación de la naturaleza y la salvaguardia de tanta diversidad biológica como sea posible son necesidades urgentes, pero estas metas parecen imposibles de alcanzar a largo plazo a menos que se contemplen dentro del marco más amplio de los problemas medioambientales en general, y estos a su vez deben considerarse junto con los problemas demográficos, tecnológicos, económicos, sociales, políticos, militares, diplomáticos, institucionales, informacionales e ideológicos a los que la humanidad tiene que hacer frente. En particular, los desafíos planteados en todos estos campos pueden contemplarse en conjunto como la necesidad de llevar a cabo una serie de transiciones interconectadas hacia una situación más sostenible en el curso del siglo actual.

Una mayor sostenibilidad, si es que puede conseguirse, significaría una estabilización de la población, a escala global y regional, unas prácticas económicas que favorezcan el pago de costes reales, el crecimiento en calidad más que en cantidad y vivir de las rentas de la naturaleza más que de su capital, una tecnología que tenga un impacto ambiental relativamente escaso, un reparto más equitativo de la riqueza, especialmente en el sentido de hacer desaparecer la miseria, unas instituciones transnacionales más fuertes para tratar los problemas globales urgentes, una opinión pública mucho mejor informada sobre los desafíos mutiples e interactivos de cara al futuro, y quizás lo más importante y difícil de todo, el predominio de actitudes que favorezcan la unidad en la diversidad (cooperación y competencia no violenta entre las diferentes naciones y tradiciones culturales) así como una coexistencia sostenible con los organismos con los que compartimos la biosfera.

Una tal situación parece utópica y quizás imposible de conseguir, pero es importante intentar construir modelos del futuro que puedan conducir a ese mundo deseable y sostenible a finales de este siglo, un mundo en el que el conjunto de la humanidad y el resto de la naturaleza funcionen como un sistema complejo adaptativo a una escala mucho mayor de lo que lo hacen en la actualidad.

Opinión Personal

Es un libro bastante técnico y conceptual que en mi opinión intenta abarcar mucho sin que haya una relación clara entre sus partes. Da la sensación de que el autor ha querido escribir sobre todo lo que ha investigado o trabajado en su vida profesional.

La primera parte sobre simplicidad, complejidad y sistemas complejos adaptativos es interesante pero a mi la que más me ha gustado es la segunda parte, el Universo Cuántico. La tercera y cuarta partes no me las he leído porque leyendo sobre su contenido en la introducción y en el postfacio he visto que no me iban a resultar interesantes.

De la primera parte me quedaría con los conceptos de complejidad, y como un sistema complejo adaptativo necesita que su entorno contenga regularidades pero también una parte aleatoria para evolucionar adaptándose a los cambios.

La empresa científica humana constituye una hermosa ilustración del concepto de sistema complejo adaptativo. Los esquemas son en este caso las teorías, y lo que tiene lugar en el mundo real es la confrontación entre la teoría y la observación.

El proceso por el que las teorías resultan seleccionadas de acuerdo con la experiencia, coherencia y generalidad no es muy diferente de la evolución biológica.

De la segunda parte lo más interesante ha sido la explicación de la Cromodinámica Cuántica, y los conceptos de decoherencia cuántica, que permite una conexión entre los mundos cuántico y clásico, e historias posibles.

También está muy bien explicado la importancia del bosón de Higgs y el concepto de ruptura espontánea de simetría de cara a revelar la simplicidad subyacente del modelo estándar.